Inhaltsverzeichnis

Was ist Stable Diffusion?

Die Welt der künstlichen Intelligenz entwickelt sich ständig weiter und bringt immer wieder beeindruckende Technologien hervor. Eine dieser Technologien ist Stable Diffusion, eine KI-gestützte Methode zur Generierung von Bildern aus Text. In diesem Blogbeitrag werde ich dir eine detaillierte Einführung in Stable Diffusion geben. Du wirst verstehen, wie dieses Verfahren funktioniert und welche Vorteile es bietet.

Stable Diffusion ist ein KI-Modell, das Bilder basierend auf Texteingaben generiert. Mit anderen Worten, es verwandelt geschriebene Beschreibungen in visuelle Darstellungen. Stable Diffusion basiert auf modernen KI-Algorithmen und ermöglicht es Benutzern, hochwertige und kreative Bilder aus ihren Textbefehlen (auch „Prompts“ genannt) zu erstellen. Diese Technologie hat zahlreiche Anwendungsmöglichkeiten, darunter Design, Marketing, Kunst und mehr.

Wie funktioniert Stable Diffusion?

Stable Diffusion verwendet neuronale Netzwerkarchitekturen, um Textbeschreibungen in Bilder umzuwandeln. Durch das Trainieren des Modells mit großen Mengen an Bilddaten lernt die KI, Muster und Strukturen aus den Daten zu erkennen und diese Informationen zur Generierung neuer Bilder zu nutzen.

Wenn Benutzer einen Textbefehl eingeben, analysiert das KI-Modell die eingegebenen Wörter und sucht nach relevanten Mustern in seinem internen Wissen. Basierend auf diesen Mustern erstellt das Modell dann ein Bild, das der Beschreibung entspricht. Der Prozess ist iterativ und kann je nach Komplexität des Textbefehls mehrere Schritte umfassen.

Vorteile von Stable Diffusion

- Open-Source: Stable Diffusion ist Open-Source, was bedeutet, dass es von einer großen Community unterstützt und ständig weiterentwickelt wird. Dies ermöglicht es Benutzern, kostenlose und leistungsstarke Tools zur Bildgenerierung zu nutzen und gemeinsam an der Verbesserung der Technologie zu arbeiten.

- Für Low-Power-Computer entwickelt: Stable Diffusion ist so konzipiert, dass es auch auf Computern mit geringer Rechenleistung effizient funktioniert. Dies macht es für viele Benutzer zugänglicher und erschwinglicher.

- Kreativität und Vielseitigkeit: Die Bildgenerierung mit Stable Diffusion ist nicht auf bestimmte Stile oder Themen beschränkt. Benutzer können eine Vielzahl von Textbefehlen verwenden, um Bilder in verschiedenen Stilen, Genres und Formaten zu generieren.

- Benutzerfreundlichkeit: Obwohl die Technologie hinter Stable Diffusion komplex ist, ist die Verwendung für Benutzer relativ einfach. Es gibt verschiedene Online-Generatoren und fortschrittliche grafische Benutzeroberflächen (GUIs), die den Einstieg erleichtern.

Wie fängt man an, Bilder zu generieren?

Es stellt sich die Frage: Wie kann man anfangen, Bilder mit dieser KI-Technologie zu generieren? In diesem Blogbeitrag werde ich die grundlegenden Schritte durchgehen, um mit Stable Diffusion zu arbeiten und beeindruckende Bilder aus Textbeschreibungen zu erstellen.

Schritt 1: Wähle einen Online-Generator oder eine erweiterte GUI

Für Einsteiger empfehle ich, mit einem kostenlosen Online-Generator zu beginnen. Es gibt verschiedene Websites, die Stable Diffusion-Dienste anbieten. Suche einfach auf Google nach „Stable Diffusion Online Generator“ und wähle einen, der deinen Anforderungen entspricht. Gib deinen Textbefehl (Prompt) ein und lass den Generator die Arbeit erledigen.

Wenn du erst einmal genügend Erfahrung gesammelt und die grundlegenden Konzepte verinnerlicht hast, steht es dir frei, zu einer fortschrittlicheren grafischen Benutzeroberfläche (GUI) überzugehen, die dir eine Vielzahl zusätzlicher Funktionen und Anpassungsmöglichkeiten zur Verfügung stellt. Eine solche GUI ist beispielsweise AUTOMATIC1111 oder NMKD – ein besonders einsteigerfreundliches Tool, das sowohl auf Cloud-Servern wie Google Colab als auch auf deinem persönlichen Computer (vorausgesetzt, du verfügst über eine geeignete NVIDIA-GPU) eingesetzt werden kann.

Schritt 2: Erstelle einen guten Textbefehl

Um qualitativ hochwertige Bilder zu erzeugen, ist es wichtig, einen aussagekräftigen Textbefehl zu erstellen. Achte darauf, dass dein Befehl detailliert und spezifisch ist, um das gewünschte Ergebnis zu erzielen. Verwende starke Schlüsselwörter, um den Stil und die Eigenschaften des Bildes zu definieren. Du kannst auch einen Prompt-Generator verwenden, um den Prozess zu vereinfachen und nützliche Schlüsselwörter zu erlernen.

Schritt 3: Parameter anpassen (optional)

Einige Online-Generatoren und erweiterte GUIs ermöglichen es, bestimmte Parameter anzupassen, um das generierte Bild weiter zu optimieren. Zu den wichtigen Parametern gehören Bildgröße, Sampling-Schritte, CFG-Skala und Seed-Wert. Experimentiere mit verschiedenen Einstellungen, um die bestmöglichen Ergebnisse zu erzielen.

Sampling-Schritte

Die Sampling-Schritte, auch bekannt als Iterationen, sind ein zentraler Faktor im Bildgenerierungsprozess. Sie bestimmen die Anzahl der Schritte, die das KI-Modell durchläuft, um das endgültige Bild zu erstellen. Je mehr Sampling-Schritte verwendet werden, desto detaillierter und schärfer wird das generierte Bild. Allerdings steigt auch die Rechenzeit, die das Modell benötigt, um das Bild zu erstellen. Ein guter Startpunkt sind mindestens 20 Sampling-Schritte, die je nach Bedarf erhöht werden können, um die Bildqualität zu verbessern.

Hier ist ein Beispiel in dem sich nur die Sampling-Schritte verändern und alle anderen Parameter gleich bleiben:

CFG-Skala

Die CFG-Skala ist ein Parameter, der beeinflusst, wie stark das KI-Modell dem eingegebenen Textbefehl (Prompt) folgen soll. Eine höhere CFG-Skala führt dazu, dass das Modell den Prompt stärker berücksichtigt und das generierte Bild enger an die Textbeschreibung angelehnt ist. Ein typischer Wert für die CFG-Skala liegt bei 7. Je nach Anwendungsfall kann dieser Wert erhöht oder verringert werden, um das gewünschte Ergebnis zu erzielen.

Hier ist ein Beispiel in dem sich nur die CFG-Skala verändern und alle anderen Parameter gleich bleiben:

Seed-Wert

Der Seed-Wert ist eine Zahl, die als Startpunkt für den Zufallsgenerator dient, der den Bildgenerierungsprozess steuert. Wenn der Seed-Wert auf -1 gesetzt ist, wird für jede Bildgenerierung ein zufälliger Startpunkt gewählt, was zu unterschiedlichen Bildern führt. Um reproduzierbare Ergebnisse zu erzielen, kann der Seed-Wert auf eine feste Zahl gesetzt werden. So wird bei jedem Durchlauf des Modells das gleiche Bild generiert.

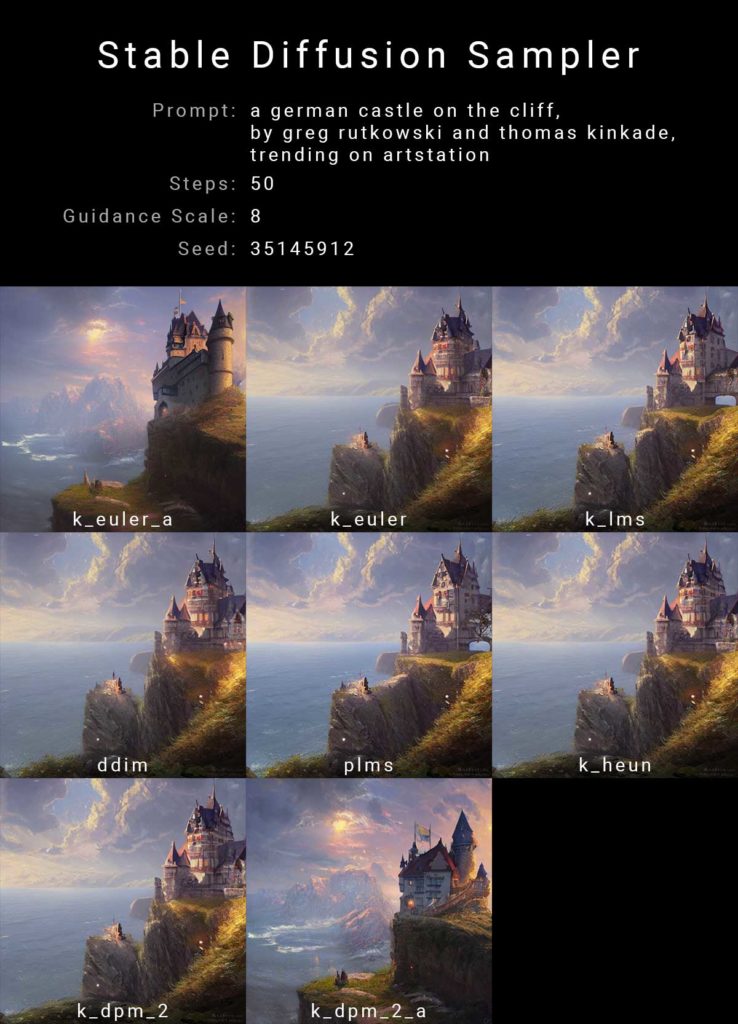

Sampler

Der Sampler von Stable Diffusion ist ein Verfahren, das es ermöglicht, neue Daten wie Bilder, Texte oder sogar Musik zu erzeugen. Dabei wird ein Prozess genutzt, der auf Rauschen und stochastischen Berechnungen basiert, um die zugrundeliegende Struktur und Muster der Eingabedaten zu erfassen.

In einfachen Worten, der Sampler von Stable Diffusion „lernt“ aus den vorhandenen Daten und nutzt diese Informationen, um realistische und kohärente neue Daten zu erzeugen. Dieser Ansatz bietet eine gute Balance zwischen Effizienz und Qualität, da er sowohl schnelle Berechnungen ermöglicht als auch realistische Ergebnisse liefert.

Hier ist ein Beispiel in dem sich nur die Sampler verändern und alle anderen Parameter gleich bleiben:

Schritt 4: Generiere und verfeinere deine Bilder

Sobald du deinen Textbefehl und die gewünschten Parameter eingegeben hast, kannst du mit der Bildgenerierung beginnen. Es ist ratsam, mehrere Bilder gleichzeitig zu generieren, um unterschiedliche Variationen zu erhalten und das beste Ergebnis auszuwählen. Überprüfe jedes generierte Bild sorgfältig und überlege, ob du den Textbefehl oder die Parameter anpassen musst, um ein noch besseres Ergebnis zu erzielen.

Schritt 5: Nutze zusätzliche Funktionen und Techniken (optional)

Mit erweiterten GUIs und weiteren Kenntnissen in Stable Diffusion kannst du zusätzliche Funktionen nutzen, wie z.B. Inpainting zur Reparatur von Bildfehlern oder das Arbeiten mit benutzerdefinierten Modellen für bestimmte Stile. Du kannst auch die Bild-zu-Bild-Funktion verwenden, um ein vorhandenes Bild als Ausgangspunkt für die Generierung zu nehmen und es entsprechend deinem Textbefehl zu modifizieren.

Ein weiterer fortgeschrittener Ansatz ist das Mischen von Bildern. Du kannst zwei oder mehr generierte Bilder miteinander kombinieren, um ein völlig neues Bild zu erstellen. Dabei könnten die besten Aspekte jedes Bildes genutzt werden, um ein noch ansprechenderes Ergebnis zu erzielen.

Was sind benutzerdefinierte Modelle?

Benutzerdefinierte Modelle sind KI-Modelle, die auf den offiziellen Basis-Modellen von Stable Diffusion oder anderen KI-Systemen aufbauen und speziell für bestimmte Bildstile oder Objekte trainiert wurden. Diese Modelle wurden entwickelt, um die Grenzen der Basis-Modelle zu erweitern und Künstlern und Designern mehr Möglichkeiten bei der Bildgenerierung zu bieten.

Hier ist ein ausführlicher Guide für Bildstile mit verschiedenen KI-Modellen.

Die offiziellen Modelle, die von Stability AI und ihren Partnern veröffentlicht wurden, werden als Basis-Modelle bezeichnet. Beispiele für Basis-Modelle sind Stable Diffusion 1.4, 1.5, 2.0 und 2.1. Benutzerdefinierte Modelle werden auf diesen Basis-Modellen aufgebaut und mit zusätzlichen Daten trainiert, um Bilder mit speziellen Stilen oder Objekten zu erzeugen.

Warum benutzerdefinierte Modelle nutzen?

Benutzerdefinierte Modelle bieten eine Reihe von Vorteilen gegenüber den Basis-Modellen. Hier sind einige Gründe, warum du benutzerdefinierte Modelle in Betracht ziehen solltest:

- Einzigartige Stile: Benutzerdefinierte Modelle ermöglichen es dir, Bilder in einem bestimmten Stil zu erzeugen, der auf deine Bedürfnisse zugeschnitten ist. Dies kann von Vorteil sein, wenn du nach einem bestimmten Look für deine Bilder suchst, der sich von den typischen Ergebnissen der Basis-Modelle abhebt.

- Verbesserte Qualität: In einigen Fällen können benutzerdefinierte Modelle dazu beitragen, die Qualität der generierten Bilder zu verbessern, indem sie auf bestimmte Problemstellungen abzielen, die in den Basis-Modellen nicht ausreichend behandelt werden.

- Spezialisierung: Benutzerdefinierte Modelle können auf bestimmte Objekte oder Szenen spezialisiert sein, die in den Basis-Modellen möglicherweise nicht so gut abgedeckt sind. Dies kann dazu führen, dass die generierten Bilder besser auf deine Anforderungen zugeschnitten sind.

Wie erstellt man benutzerdefinierte Modelle?

Um ein benutzerdefiniertes Modell zu erstellen, benötigst du zunächst eine geeignete Datensammlung, die den gewünschten Stil oder die gewünschten Objekte repräsentiert. Diese Daten können aus verschiedenen Quellen stammen, z.B. aus eigenen Kunstwerken, Fotos oder Online-Bildersammlungen. Es ist wichtig, dass die Datensammlung ausreichend groß und vielfältig ist, um dem Modell genügend Informationen für das Training zu bieten.

Sobald du über eine geeignete Datensammlung verfügst, musst du das benutzerdefinierte Modell trainieren. Dieser Prozess beinhaltet die Verwendung eines Basis-Modells (z.B. Stable Diffusion 1.4 oder 1.5) und die Anpassung des Modells an deine spezifischen Anforderungen durch das Training mit deinen Daten. Das Training kann auf verschiedene Weise durchgeführt werden, z.B. mit Dreambooth oder Embedding-Techniken. Dabei kann es hilfreich sein, einen leistungsstarken Computer oder Cloud-Dienste zu verwenden, um das Training zu beschleunigen und die besten Ergebnisse zu erzielen.

Nachdem das benutzerdefinierte Modell erfolgreich trainiert wurde, kannst du es zur Bildgenerierung verwenden. Achte darauf, das Modell regelmäßig zu testen und gegebenenfalls Anpassungen vorzunehmen, um sicherzustellen, dass es den gewünschten Ergebnissen entspricht.

Negative Textbefehle (Negative Prompts)

Negative Textbefehle, auch als „Negative Prompts“ bezeichnet, sind ein leistungsfähiges Werkzeug, um die KI-generierten Bilder in Stable Diffusion weiter zu verfeinern und zu optimieren.

Was sind Negative Prompts?

Negative Prompts sind Textbefehle, die dazu dienen, unerwünschte Merkmale oder Aspekte aus den generierten Bildern zu entfernen oder zu reduzieren. Im Gegensatz zu normalen Prompts, die beschreiben, was in einem Bild erscheinen soll, geben Negative Prompts der KI Anweisungen darüber, was nicht im Bild enthalten sein soll. Dies kann dazu beitragen, die Bildqualität zu verbessern und die Genauigkeit der KI bei der Umsetzung der gewünschten Szenen und Objekte zu erhöhen.

Wie verwendet man Negative Prompts?

Um Negative Prompts effektiv zu nutzen, sollten sie zusammen mit den normalen Prompts verwendet werden. Dabei sollte man darauf achten, dass die Negative Prompts klar und präzise formuliert sind, um Missverständnisse und unerwünschte Ergebnisse zu vermeiden.

Ein Beispiel: Wenn du ein Bild eines Gartens ohne Menschen generieren möchtest, könntest du als normalen Prompt „Garten mit Blumen und Bäumen“ und als Negative Prompts „keine Menschen, keine Personen, keine Figuren“ verwenden. Auf diese Weise gibst du der KI die Anweisung, den gewünschten Garten zu generieren, jedoch ohne menschliche Elemente einzufügen.

Warum sind Negative Prompts wichtig?

Negative Prompts sind besonders wichtig bei der Verwendung von Stable Diffusion KI, da sie dazu beitragen können, die Bildqualität und Genauigkeit zu verbessern. Insbesondere bei den v2-Modellen (z.B. Stable Diffusion 2.0 und 2.1) sind Negative Prompts unerlässlich, um optimale Ergebnisse zu erzielen.

Auch bei v1-Modellen (z.B. Stable Diffusion 1.4 und 1.5) können Negative Prompts hilfreich sein, um unerwünschte Elemente aus den generierten Bildern zu entfernen und die KI besser auf die gewünschten Szenen und Objekte auszurichten.

Vielen Dank für dieses gut aufbereitete Manual, welches mir sehr geholfen hat. Vor allem die Beispiele mit den unterschiedlcihen Bildern durch die Änderung nur eines Parameters waren sehr aufschlussreich. Für die viele Arbeit, die in diesen Beitrag geflossen ist, möchte ich mich auf diesem Wege ganz herzlich bedanken.

Vielen Dank, das höre ich gerne. Das Thema Stable Diffusion fasziniert mich sehr, da man damit KI Bilder auf dem eigenen PC erstellen kann.

Viele Grüße

Hallo, tolles Werkzeug. Bis jetzt habe ich aber noch keinen Weg gefunden, dass zu bekommen was ich mir vorgestellt habe. Ich würde mich über Hilfen zu den einzelnen Parametern freuen.

Oder eine Schritt für Schritt Anleitung die mit der Standardkofiguration funktioniert.

Bis jetzt habe ich fast nur bute bildchen mit wenig gebrauchswert gefunden.

Die Anleitung hier ist da schon ein richtiger Lichtblick. Danke dafür.

Danke, ich hatte ohnehin vor demnächst eine kleine Anleitung genau über dieses Thema zu machen.

Ich bin schon sehr gespannt auf die erwähnte Anleitung. Ich möchte gern Cartoons erstellen, vielleicht finde ich in der Anleitung Hinweise dazu, wie ich mehrere Bilder mit den gleichen Personen in unterschiedlichen Situationen generieren kann.

Moin,

vielen Dank für die Erklärungen.

Eine Frage zu den negativen Prompts:

Wenn ich ein Bild ohne Menschen haben möchte, muß ich dann bei negativen prompts ‚Menschen‘ oder ‚keine Menschen‘ eintragen?

Von meinem Verständnis wäre ‚keine Menschen‘ doch eher doppelte Verneinung; ich gebe bei Negativprompts doch an, was ich eben nicht haben möchte.

Und wenn ich ‚keine Menschen‘ eben NICHT haben möchte, ja, dann will ich doch Menschen haben.

Oder nicht?

MfG Inu

Dein Gedankengang ist korrekt, bei den negativen Prompts schreibst du zum Beispiel Menschen, Personen, Bäume usw. hinein wenn du diese nicht haben willst.