KI-Bildgeneratoren sind gerade ein Thema mit großem Interesse, doch können lokale Lösungen ein wenig kompliziert sein. Mit dem Tool NMKD Stable Diffusion GUI ist es sehr einfach, da das Programm viele dinge voll automatisch macht.

Inhaltsverzeichnis

Stable Diffusion ist ein KI-Model dass von Stability.ai entwickelt wurde und kostenlos zur Verfügung gestellt wird. Wie bei anderen KI-Bildgeneratoren zum Beispiel DALL-E 2 oder Midjourney kann man mit Stable Diffusion durch Texteingaben Bilder erzeugen lassen.

In der Regel kann man solche KI-Bildgeneratoren nur in der Cloud nutzen und bezahlt natürlich dafür. Da Stable Diffusion aber kostenlos zur Verfügung steht, gibt es schon einige Lösungen um das ganze am eigenen Rechner laufen zu lassen.

Viele Lösungen können aber etwas komplizierter sein, genau da kommt NMKD Stable Diffusion GUI ins Spiel. Dieses Programm ist sehr Einfach zu handhaben.

Voraussetzungen

Diese Software funktioniert nur unter Windows und mit NVIDIA Grafikkarten.

- Windows 10/11

- NVIDIA Grafikkarte mit mindestens 3 GB VRAM

- 16 GB RAM

- ~11 GB Festplattenspeicher

NMKD Stable Diffusion GUI Installieren

Auf nmkd.itch.io/t2i-gui kann das Programm als komprimierte Datei heruntergeladen werden.

Entpacke die Datei in einem Ordner und starte die Datei StableDiffusionGui.exe

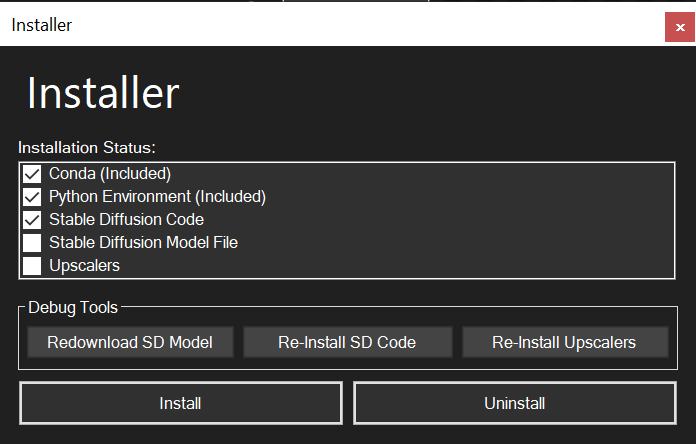

Es öffnet sich ein „Installer“ Fenster, hier kannst du alle Häkchen setzen und auf „Install“ klicken.

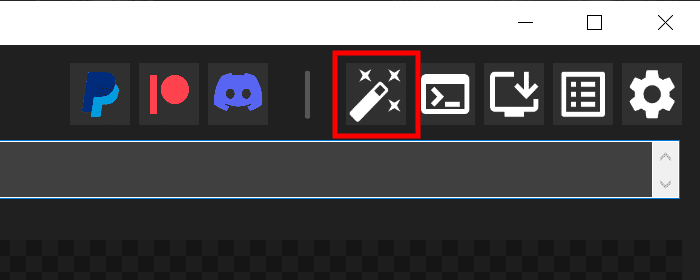

Jetzt fehlt noch eine Kleinigkeit, klicke auf den Button „Post-Processing“ und stelle „Upscaling“ auf „4x„, „Face Restauration“ auf „GFPGAN“ und die Stärke auf „1„.

Die Benutzeroberfläche

Post-Processing

Hier kannst du das „Upscaling“ und „Face Restauration“ aktivieren.

Developer Tools

Wer sich intensiver mit dem Programm beschäftigen will, der bekommt hier ein paar Tools.

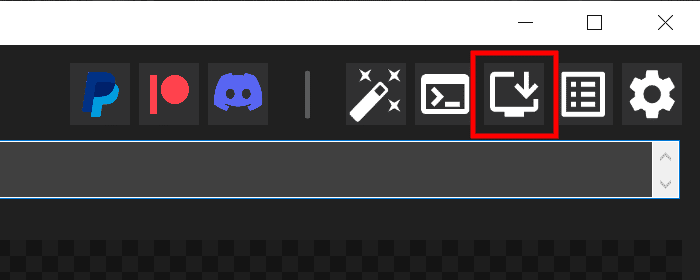

Installer

Hier können die Komponenten installiert, deinstalliert oder neu heruntergeladen werden.

Logs

Hier bekommst du zugriff auf die Logs.

Settings

In den Einstellungen können gewisse Dinge eingestellt werden wie die Stable Duffusion Model Datei, welche Grafikkarte verwendet werden soll, wo die generierten Bilder gespeichert werden sollen und wie deren Dateinamen strukturiert sein sollen.

Prompt

Hier kannst du zusätzlich zum eingegebenen Text ein Bild Laden um das Ergebnis dementsprechend zu beeinflussen.

Du kannst maximal 55 Wörter angeben, wenn du mehr schreibst werden diese ignoriert.

Amount of image to generate

Hier kannst du angeben wie viele Bilder hintereinander erstellt werden sollen.

Das kann dann praktisch sein wenn du einen guten Prompt gefunden hast und mehrere Bilder in diesem Stil generieren willst.

Details (Steps)

Die Steps geben an wie detailreich das Bild wird, je höher diese Zahl umso detailreicher.

Jedoch ist mehr nicht immer besser, oft gibt es bei einer Steps-Anzahl von 30 keine merkenswerten Unterschiede. Da muss man etwas experimentieren, aber zwischen 30 und 50 kann man ein wenig herumspielen.

Was auch zu bedenken ist, je höher die Steps-Anzahl, desto länger wird für die Generierung benötigt.

Hier habe ich in einem Beispiel alle Werte exakt gleich lassen und nur die Steps von 10 bis 120 jeweils um 10 erhöht, man kann also ganz gut die Unterschiede erkennen.

Creativeness (Guidance Scale)

Die Guidance Scale gibt an wie sehr sich die KI an deinen Prompt hält.

Je geringer die Scale-Zahl desto mehr Freiheiten hat die KI und je höher desto mehr hält sie sich an die eingegebenen Begriffe.

Seed

Das Seed Textfeld ist standardmäßig leer, das bedeutet es wird eine zufällige Zahl jedes mal generiert.

Dadurch generiert die KI jedes mal etwas anderes, wenn du also eine Zahl selbst eingibst und alle anderen Werte gleich lässt, dann kommt immer das gleiche Bild heraus.

Resolution

Das bestimmt die Auflösung, ich würde die Standardwerte von 512 x 512 Pixel belassen, denn je mehr Pixel desto länger dauert die Bildgenerierung.

Um doch ein größeres Bild zu bekommen stellst bei „Post Processing“ das Upscaling auf 4x, dadurch bekommst du ein Bild mit 2048 x 2048 Pixel.

Die Auflösung würde ich nur dann erhöhen wenn du eine starke Grafikkarte hast.

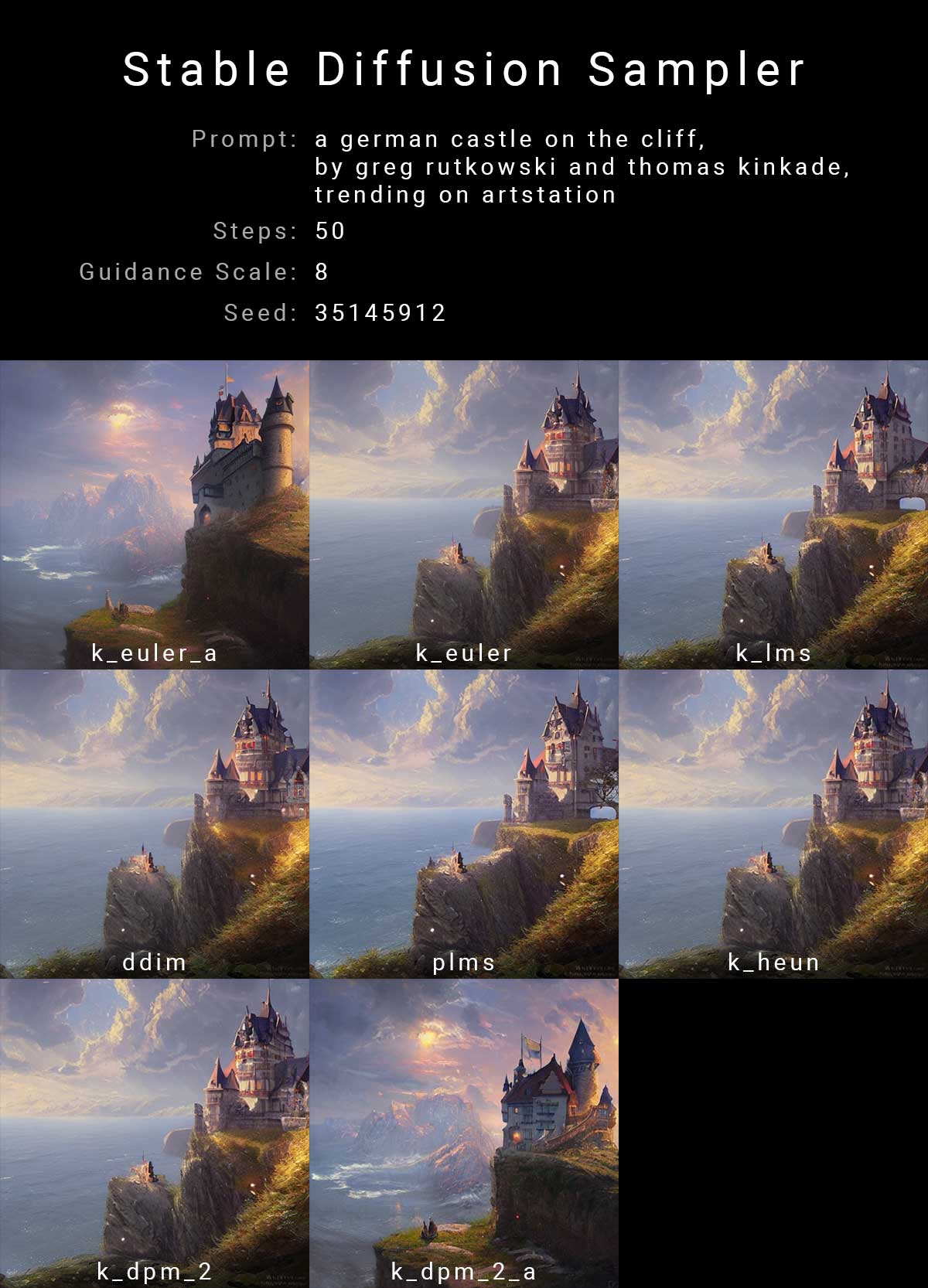

Sampler

Die Ki erzeugt die Bilder immer mit einem Bildrauschen als Ausgangspunkt, die verschiedenen Sampler sind für das Bildrauschen zuständig und können unterschiedliche Ergebnisse erzeugen.

Im Bild darunter habe ich ein Bild mit den verschiedenen Sampler erzeugt.

Seamless (Tileable) Image

Diese Funktion soll Texturen oder Muster erzeugen die nahtlos nebeneinander gelegt werden.

Meine bisherigen Versuche funktionierten aber nicht wirklich.

Ausgabe

Auf der rechten Seite kannst du mit einem klick auf den Button „Generate!“ ein Bild erzeugen lassen.

Mit den anderen Buttons daneben kannst du noch weiteres machen, diese sind aber selbsterklärend. Einfach mit der Maus darüber fahren und du siehst eine Beschreibung.

KI-Bilder erzeugen

Jetzt kannst du loslegen und in das Textfeld deinen Text auf englisch eingeben wie das Bild sein soll.

Dein eingegebene Text wird allgemein „Prompt“ genannt, falls du also nach Tipps im Internet suchst musst du zum Beispiel nach „Stable Diffusion Prompt Tipps“ suchen.

Prompt

Die KI generiert zwar das Bild in Sekunden, doch das schwierige ist der richtige Prompt.

Das gute ist, es gibt eine Webseite, die Stable Diffusion Bilder sammelt unter lexica.art

Hier kannst du nach bestimmten Themen suchen, wenn du dann auf ein Bild klickst bekommst du die Details dazu.

Du siehst hier den Prompt der benutzt wurde, den Seed und Scale.

Mit einem klick auf den Button „Copy prompt“ kannst du diesen Prompt in dein Programm kopieren und selbst ein Bild in diesem Stil erzeugen.

Als Einstiegspunkt kann das sehr gut sein. Verwende das und verändere gewisse Wörter, dann musst du nicht von null anfangen.